El uso de inteligencia artificial (IA) para crear y difundir desinformación se ha vuelto cada vez más común. Esta nueva amenaza representa un desafío significativo para la conciencia pública y la integridad democrática, ya que la tecnología permite crear contenido falso cada vez más convincente.

“La desinformación generada por IA es particularmente peligrosa porque puede ser muy difícil de detectar a simple vista,” explica Ana María Carrano, editora en jefe de Factchequeado, que ha desarrollado, con el apoyo de PEN America, un recursero para ayudar a los personas a identificar contenido creado o manipulado mediante herramientas de inteligencia artificial.

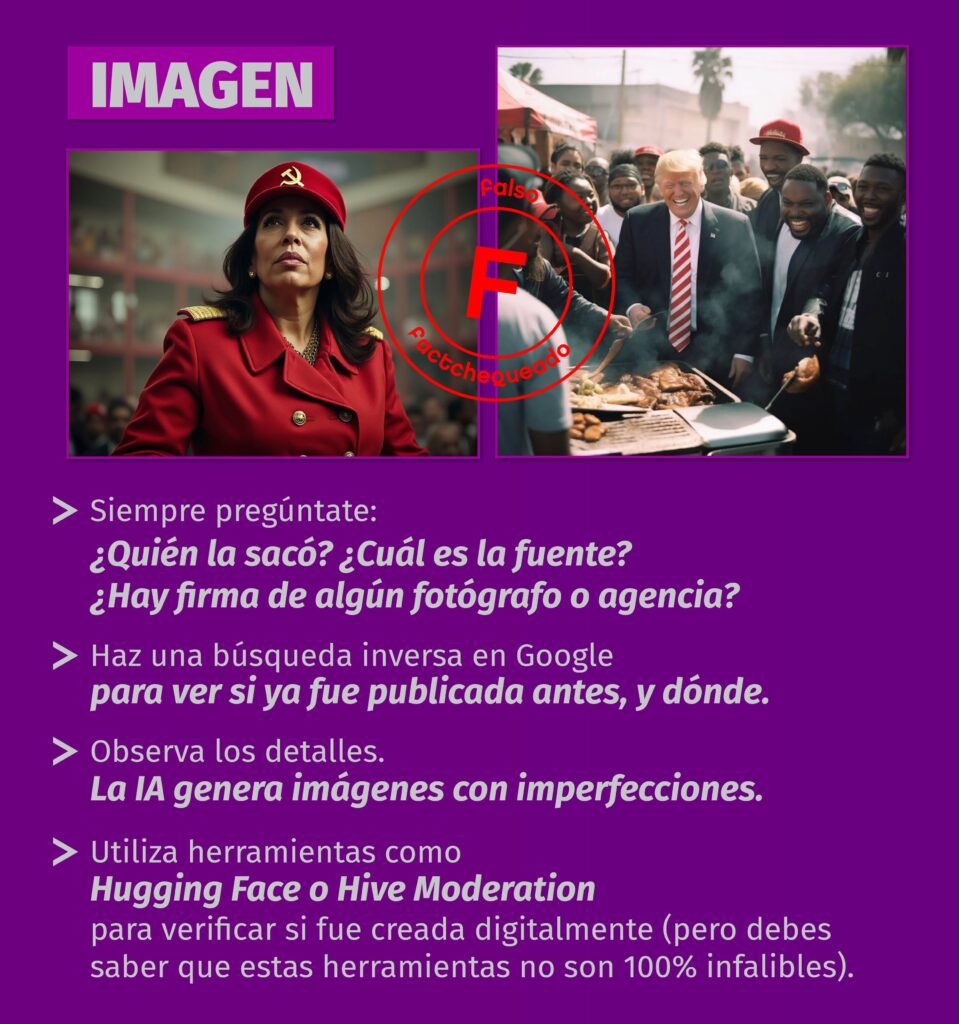

En imágenes

Observar detalles como dedos, ojos y sombras irregulares. También se puede hacer una búsqueda inversa de la imagen que se quiere analizar, para ver si se encuentra la fuente original o imágenes similares que muestren otros contextos.

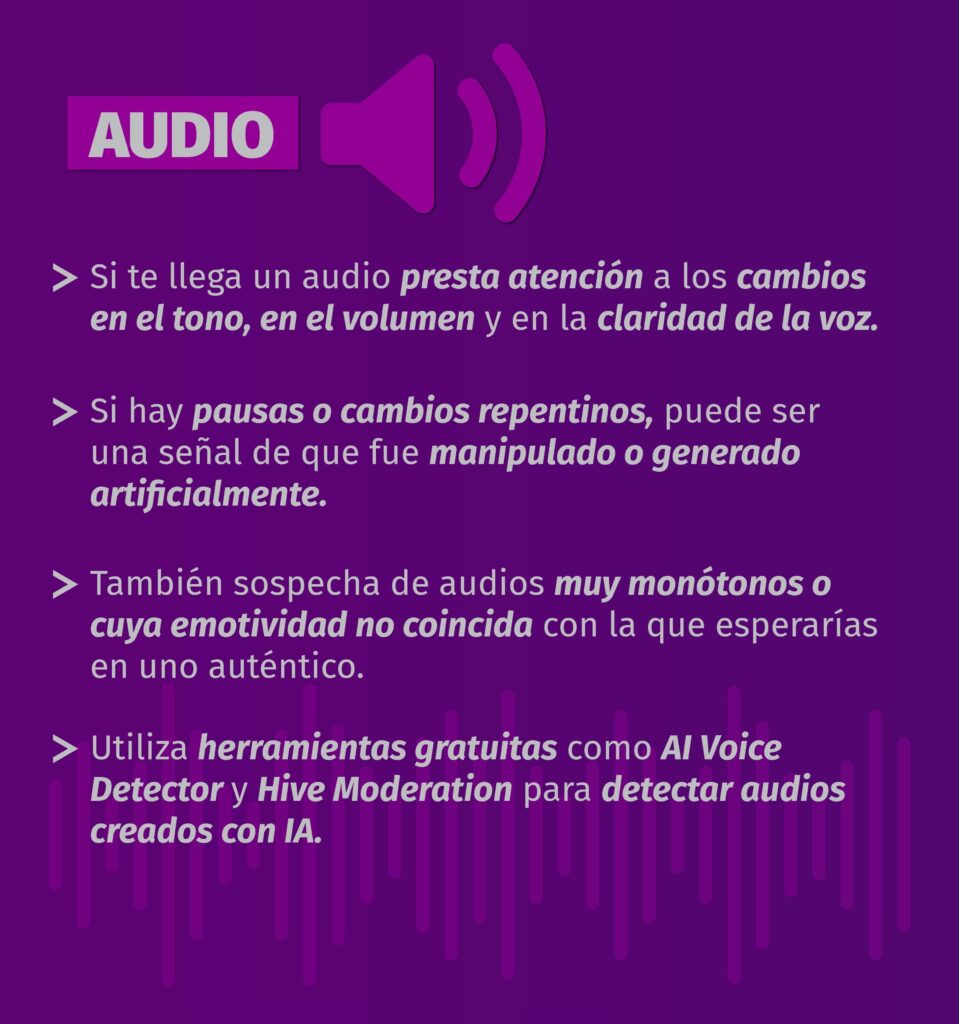

En audio

Identificar cambios abruptos en el tono o emotividad poco natural. Prestar atención si el audio tiene efectos especiales o música de fondo, porque ello hace que las herramientas que detectan IA fallen más.

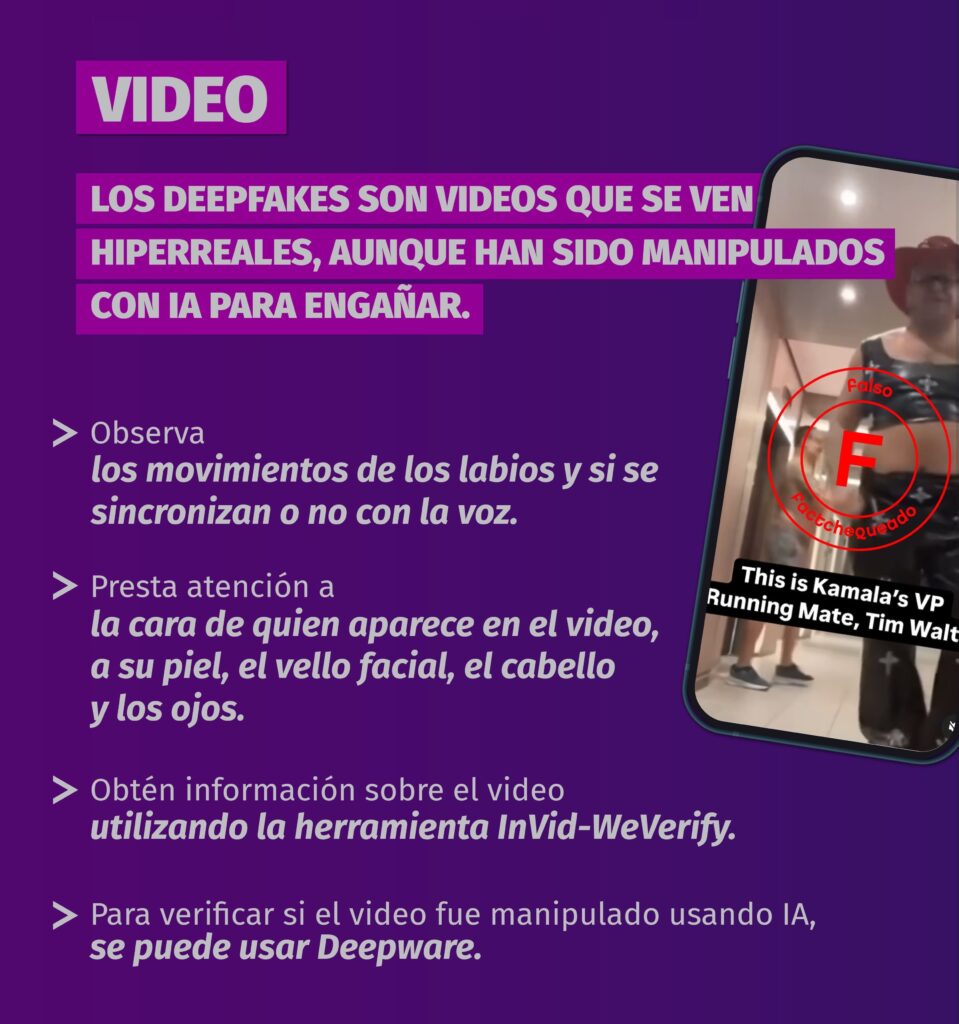

En videos

Estar especialmente atentos a la sincronización labial con el audio y textura de la piel de las personas, la IA suele mostrarnos pieles más tersas que las reales.

En textos

Verificar la información con sitios web confiables y desconfiar especialmente del contenido que genera emociones extremas.

Si tras la observación y el uso de tus sentidos, no estás seguro de la autenticidad de un contenido, Factchequeado recomienda utilizar herramientas de verificación como Hugging Face para imágenes, AI Voice Detector para audio y Deepware para videos o Hive Moderation, que sirve para los tres formatos. Aunque debes saber que ninguna herramienta es 100% fiable y cada una arroja un porcentaje de probabilidad de que un contenido haya sido generado con IA.

“Además de usar estas herramientas (que son actualmente algunas de las que mejor funcionan), es clave mantenerse actualizado porque evolucionan rápidamente,” advierte Nira Dinerstein, coordinadora de proyectos especiales de Educación de Chequeado. Y recuerda siempre que la mejor defensa es la verificación cruzada con fuentes confiables (fuentes oficiales, medios profesionales, instituciones académicas, organizaciones que trabajan el tema del que se informa) antes de compartir cualquier contenido.

“Es crucial leer críticamente el contexto en el que aparece el contenido sospechoso,” señala Carrano. “Preguntarse qué está pasando respecto de ese tema, si el contenido o uno similar fue publicado antes, quién lo difundió, cuál es la evidencia presentada y qué dicen otras fuentes confiables al respecto nos da pistas clave para evaluar su veracidad.”

Se recomienda siempre buscar la fuente original del contenido. Y, si no encuentras una fuente confiable que respalde la imagen, audio, video o texto, la regla es simple: no compartas el contenido si es informativo.

¿Tiene problemas para verificar? Pregúntale a Factchequeado.

Algunos ejemplos

- “Cómo la nueva versión de Grok, la IA de Elon Musk en X, se está usando para generar imágenes violentas, vejatorias y sexualizadas de figuras políticas y famosas”

- “No, esta no es una foto de Trump en un barbecue en el Bronx: fue generada con Inteligencia Artificial (AI)”

- “Cuidado con voces y videos que suplantan a famosos para intentar engañarte”